Digitale transformatie is een hot topic voor alle markten en industrieën, omdat het waarde levert met explosieve groeipercentages. Bedenk dat het Industry Internet of Things (IIOT) van de maakindustrie werd gewaardeerd op $ 161 miljard met een indrukwekkend groeipercentage van 25%, de markt voor geconnecteerde auto's tegen 2027 zal worden gewaardeerd op $ 225 miljard met een groeipercentage van 17%, of dat in de eerste drie maanden van In 2020 realiseerden retailers tien jaar digitale verkooppenetratie in slechts drie maanden. Het meeste van wat er is geschreven, heeft echter te maken met de ondersteunende technologieplatforms (cloud- of edge- of puntoplossingen zoals datawarehouses) of use-cases die deze voordelen stimuleren (voorspellende analyse toegepast op preventief onderhoud, fraudedetectie van financiële instellingen of voorspellende gezondheidsmonitoring als voorbeelden) niet de onderliggende gegevens. Het ontbrekende hoofdstuk gaat niet over puntoplossingen of de volwassenheidsreis van use cases. Het ontbrekende hoofdstuk gaat over de gegevens - het gaat altijd over de gegevens - en, belangrijker nog, de reisgegevens weven van edge naar inzicht in kunstmatige intelligentie.

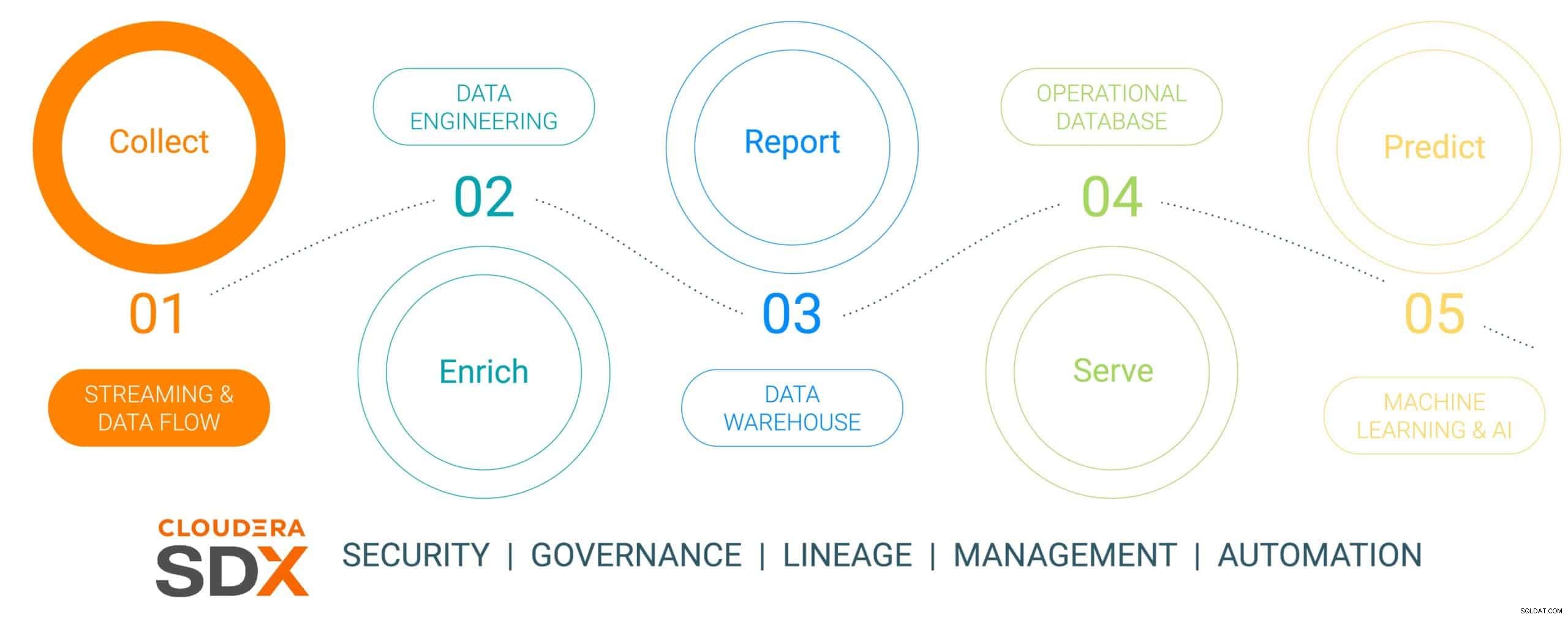

Dit is de eerste in een zesdelige blogserie waarin de datareis van edge naar AI wordt geschetst en de bedrijfswaarde die data tijdens de reis produceert. Het datatraject is niet lineair, maar het is een datalevenscyclus met een oneindige lus - initiërend aan de rand, weven door een dataplatform en resulterend in zakelijke noodzakelijke inzichten die worden toegepast op echte bedrijfskritieke problemen die resulteren in nieuwe datagestuurde initiatieven. We hebben deze reis vereenvoudigd tot vijf afzonderlijke stappen met een gemeenschappelijke zesde stap die spreekt over gegevensbeveiliging en -beheer. De zes stappen zijn:

- Gegevensverzameling – gegevensopname en monitoring aan de rand (of de rand nu industriële sensoren zijn of mensen in een fysieke winkel)

- Gegevensverrijking - verwerking, aggregatie en beheer van gegevenspijplijnen om de gegevens klaar te maken voor verdere verfijning

- Rapportage – het leveren van inzicht in zakelijke ondernemingen (verkoopanalyse en prognoses, marktonderzoek, budgettering als voorbeelden)

- Bedienen – controle en uitvoering van essentiële bedrijfsactiviteiten (geldautomaattransacties, kassa-afhandeling in de detailhandel of productiebewaking)

- Voorspellende analyse – voorspellende analyses op basis van AI en machine learning (fraudedetectie, voorspellend onderhoud, vraaggebaseerde voorraadoptimalisatie als voorbeelden)

- Beveiliging en bestuur – een geïntegreerde set van beveiligings-, beheer- en governancetechnologieën over de gehele levenscyclus van gegevens

Fig 1:De levenscyclus van bedrijfsgegevens

Om de datareis te illustreren, hebben we een zeer relevant en duurzaam georiënteerd productieonderwerp gekozen:de productie van een elektrische auto, gekozen omdat de productieactiviteiten meestal revolutionair van aard zijn (hoge digitale volwassenheid met gebruik van de meest up-to-date datatools) , vergeleken met "old-school evolutionair" (van lagere volwassenheid) en dat de meeste van deze auto's zijn gebouwd als Connected Mobility-platforms, waardoor de auto meer is dan alleen transport, maar een platform voor datagedreven kennis en inzicht. Dit verhaal laat zien hoe gegevens worden verzameld, verrijkt, opgeslagen, geserveerd en vervolgens gebruikt om gebeurtenissen in het productieproces van de auto te voorspellen met behulp van Cloudera Data Platform.

Dit verhaal gaat over een nagebootst bedrijf dat elektrische voertuigen produceert, met de naam (met de hoogst originele naam) The Electric Car Company (ECC). ECC heeft meerdere productiefabrieken over de hele wereld, is verticaal geïntegreerd en bouwt zijn eigen auto's en veel van de kritieke componenten, waaronder elektromotoren, batterijen en hulponderdelen. Elke fabriek is belast met de productie van verschillende componenten, waarbij de eindassemblage plaatsvindt in een paar geselecteerde, strategisch gelegen fabrieken.

Uitdaging voor gegevensverzameling

Het beheren van de verzameling van alle gegevens van alle fabrieken in het productieproces is een belangrijke onderneming die een aantal uitdagingen met zich meebrengt:

- Moeilijkheden bij het inschatten van het volume en de verscheidenheid aan IoT-gegevens: Veel fabrieken gebruiken zowel moderne als oudere productiemiddelen en apparaten van meerdere leveranciers, met verschillende protocollen en gegevensindelingen. Hoewel de controllers en apparaten verbonden kunnen zijn met een OT-systeem, zijn ze meestal niet zo verbonden dat ze de gegevens ook gemakkelijk met IT-systemen kunnen delen. Om geconnecteerde productie en opkomende IoT-gebruiksgevallen mogelijk te maken, heeft ECC een oplossing nodig die alle soorten uiteenlopende datastructuren en -schema's vanaf de rand kan verwerken, de gegevens kan normaliseren en deze vervolgens kan delen met elk type gegevensconsument, inclusief Big Data-applicaties.

- De complexiteit van realtime gegevens beheren: Om ervoor te zorgen dat ECC predictive analytics use cases aanstuurt, moet een datamanagementplatform realtime analytics op streaming data mogelijk maken. Het platform moet de streaminggegevens ook effectief in realtime of bijna realtime opnemen, opslaan en verwerken om direct inzichten en actie te kunnen leveren.

- Gegevens vrijmaken uit onafhankelijke silo's: Gespecialiseerde processen (innovatieplatforms, QMS, MES, enz.) binnen de productiewaardeketen belonen ongelijksoortige gegevensbronnen en gegevensbeheerplatforms die zijn afgestemd op unieke silo-oplossingen. Deze niche-oplossingen beperken de bedrijfswaarde, gezien slechts een fractie van het inzicht dat bedrijfsoverschrijdende gegevens kunnen bieden, terwijl het bedrijf wordt verdeeld en samenwerkingsmogelijkheden worden beperkt. Het juiste platform moet in staat zijn om streaminggegevens van alle punten in de waardeketen op te nemen, op te slaan, te beheren, te analyseren en te verwerken, te combineren met gegevenshistorici, ERP-, MES- en QMS-bronnen en deze te gebruiken voor bruikbare inzichten. Deze inzichten zullen dashboards, rapporten en voorspellende analyses opleveren die hoogwaardige gebruiksscenario's in de productie stimuleren.

- De rand in evenwicht brengen: Het is een uitdaging om de juiste balans te vinden tussen gegevensverwerking aan de edge en in de cloud, en daarom moet de volledige levenscyclus van gegevens worden overwogen. Er is een verontrustende trend in de branche, aangezien bedrijven ervoor kiezen om zich op het een of het ander te concentreren zonder te beseffen dat ze beide kunnen en moeten doen. Cloudcomputing heeft zijn voordelen voor langetermijnanalyse en grootschalige implementatie, maar wordt beperkt door bandbreedte en verzamelt vaak enorme hoeveelheden gegevens terwijl slechts een klein deel wordt gebruikt. De waarde van de edge ligt in het optreden aan de edge waar het de grootste impact heeft zonder latentie voordat het de meest waardevolle gegevens naar de cloud stuurt voor verdere hoogwaardige verwerking.

Gegevensverzameling met Cloudera Data Platform

STAP 1:Verzamelen van de onbewerkte gegevens

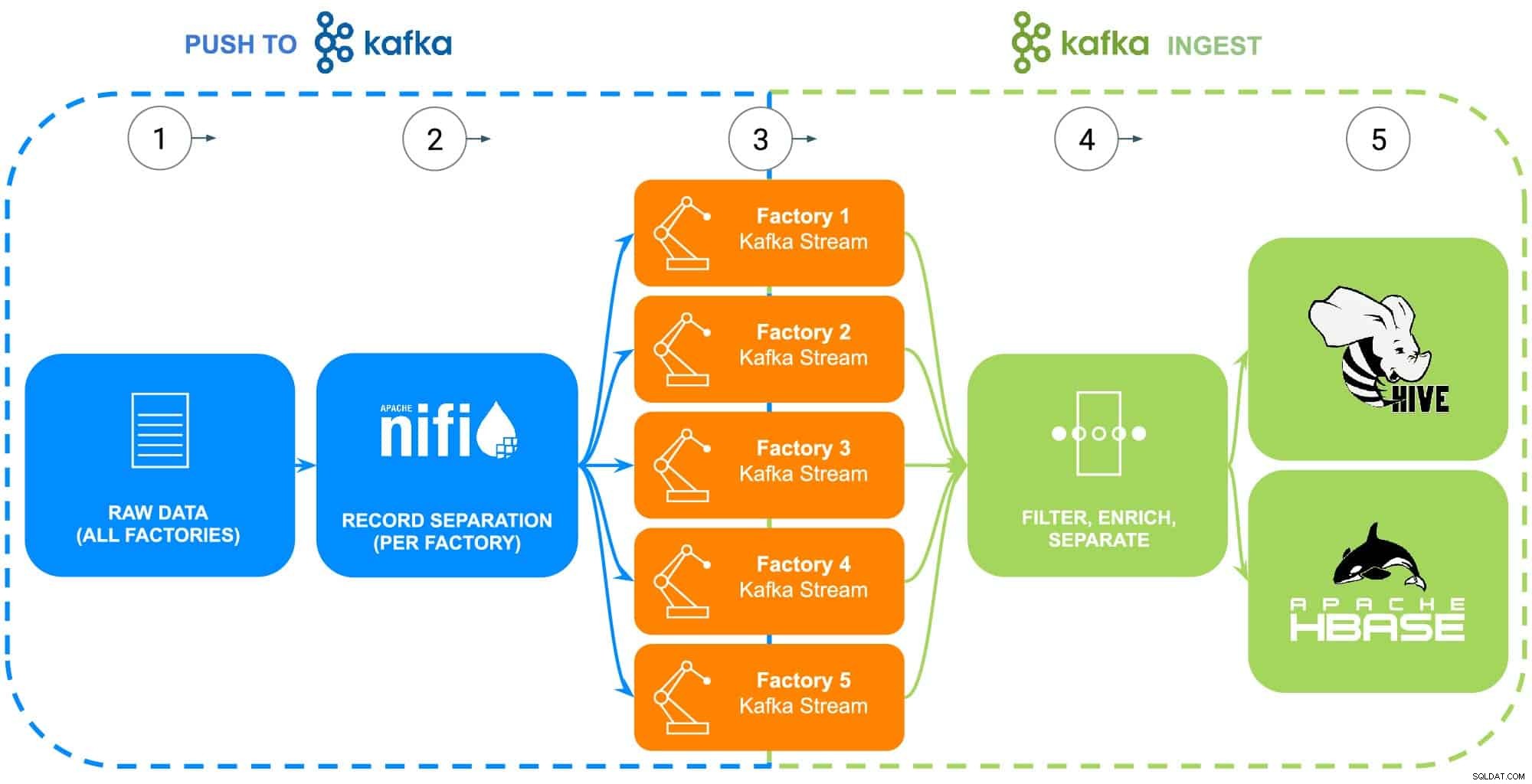

Gegevens van ECC's productieactiviteiten omvatten een groot aantal bronnen - industriële robots, body-in-white fosfaatcoatingprocestanks (temperatuur, concentratie of aanvulling), supply chain-telematica of hoofdonderdeelinformatie, enz. Voor dit specifieke voorbeeld is het onbewerkte onderdeel stamgegevens voor elk van de vijf fabrieken van ECC zijn verzameld ter voorbereiding om naar Apache NiFi te worden gevoerd (zie figuur 2).

STAP 2:Configureer gegevensbronnen voor elke fabriek

Het verzamelen van gegevens zal worden geïllustreerd met behulp van Cloudera's Data Flow-ervaring (aangedreven door Apache NiFi) om deze onbewerkte gegevens op te halen en op te splitsen in afzonderlijke fabrieksstromen (beheerd door Apache Kafka) om nauwkeuriger op een realistisch scenario te lijken (zie figuur 2). Om het voorbeeld eenvoudig te houden, zijn de volgende data-attribuuttags gekozen voor elk onderdeel dat door de fabrieken wordt gegenereerd:

- Fabrieks-ID

- Machine-ID

- Gefabriceerde tijdstempel

- Artikelnummer

- Serienummer

Fig 2:Stroomdiagram gegevensverzameling.

STAP 3:Bewaak de gegevensdoorvoer van elke fabriek

Nu alle gegevens in afzonderlijke Kafka-streams stromen, bewaakt een gegevensarchitect de gegevensdoorvoer van elke fabriek en past hij de benodigde reken- en opslagbronnen aan om ervoor te zorgen dat elke fabriek de vereiste doorvoer heeft om gegevens naar het platform te sturen.

STAP 4:Gegevens vastleggen van Apache Kafka-streams

Kafka legt alle fabrieksgegevensstromen vast en verzamelt deze in processors die zowel filteren als verrijken voor gebruik bij het controleren en uitvoeren van essentiële bedrijfsactiviteiten die worden aangedreven door een operationele database, of het leveren van bedrijfsinzichten via een bedrijfsdatawarehouse of worden gebruikt in geavanceerde analyses.

ECC is onlangs begonnen met de productie van een verbeterde versie van hun elektromotor die alleen in fabriek 5 wordt geproduceerd. Deze gegevens zullen worden gebruikt als illustratie van de volgende stappen in de gegevenslevenscyclus

STAP 5:Gegevens naar opslagoplossingen pushen

Aangezien de productie- en kwaliteitsingenieurs van ECC de inzet en het gebruik in het veld van deze motor nauwlettend willen volgen, worden de specifieke traceerbaarheidsgegevens van de fabricage gefilterd in een aparte route en opgeslagen in een eigen tabel in Apache Hive. Hierdoor kunnen de technici later ad-hocquery's in Cloudera Data Warehouse uitvoeren op de gegevens en deze koppelen aan andere relevante gegevens in het enterprise datawarehouse, zoals reparatieorders of klantfeedback om vooraf gebruiksscenario's zoals garantie, voorspellende onderhoudsroutines of input voor productontwikkeling.

Als alternatief, als het controleren en uitvoeren van essentiële bedrijfsactiviteiten gewenst is, wordt de volledige dataset met de toevoeging van een verwerkte tijdstempel verzonden naar de Apache HBase aangedreven Cloudera Operational Database. Deze gegevens zullen dienen als de basis voor ECC om hun inventarisplatform te runnen, waarvoor constante lees-/schrijfbewerkingen nodig zijn, aangezien inventaris duizenden keren per dag kan worden toegevoegd en verwijderd. Omdat HBase is ontworpen om dit soort datatransacties op grote schaal af te handelen, is het de beste oplossing voor deze unieke uitdaging.

Conclusie

Deze eenvoudige illustratie laat zien hoe belangrijk het is om gegevens goed op te nemen, aangezien dit de basis vormt voor inzichten die worden geleverd vanuit zowel operationele databases, enterprise datawarehouses als geavanceerde analytische voorspellende analyses voor machine learning. Waarde bij "het goed doen" omvat het gebruik van gegevens uit elke bedrijfsbron, waardoor gegevenssilo's worden afgebroken, het gebruik van alle gegevens, of het nu gaat om streaming of batchgewijs, en de mogelijkheid om die gegevens naar de juiste plaats te sturen, waardoor het gewenste downstream-inzicht ontstaat.

Met behulp van CDP kunnen ECC-gegevensingenieurs en andere zakelijke gebruikers de verzamelde gegevens gaan gebruiken voor verschillende taken, variërend van voorraadbeheer tot onderdelenprognoses tot machine learning. Aangezien Cloudera Data Flow realtime gegevensopname van elke bedrijfsbron bevordert, kan het worden uitgebreid en onderhouden zonder uitgebreide kennis van verschillende programmeertalen en eigen methoden voor het verzamelen van gegevens. Als zich unieke problemen voordoen, kunnen technici ook hun eigen processen creëren voor echt, fijnmazige controle.

Zoek naar de volgende blog die ingaat op gegevensverrijking en hoe deze het verhaal van de gegevenslevenscyclus ondersteunt. Daarnaast wordt dit verhaal aangevuld met datagestuurde demo's die de datareis door elke stap van de datalevenscyclus laten zien.

Meer bronnen voor gegevensverzameling

Om dit alles in actie te zien, klikt u op de gerelateerde links hieronder voor meer informatie over gegevensverzameling:

- Video – Als je wilt zien en horen hoe dit is gebouwd, bekijk dan de video via de link.

- Tutorials – Als je dit in je eigen tempo wilt doen, bekijk dan een gedetailleerd overzicht met screenshots en regel voor regel instructies over hoe je dit kunt instellen en uitvoeren.

- Meetup – Als je rechtstreeks met experts van Cloudera wilt praten, neem dan deel aan een virtuele meetup om een livestreampresentatie te zien. Aan het einde is er tijd voor directe Q&A.

- Gebruikers – Klik op de link om meer technische inhoud te zien die specifiek is voor gebruikers.