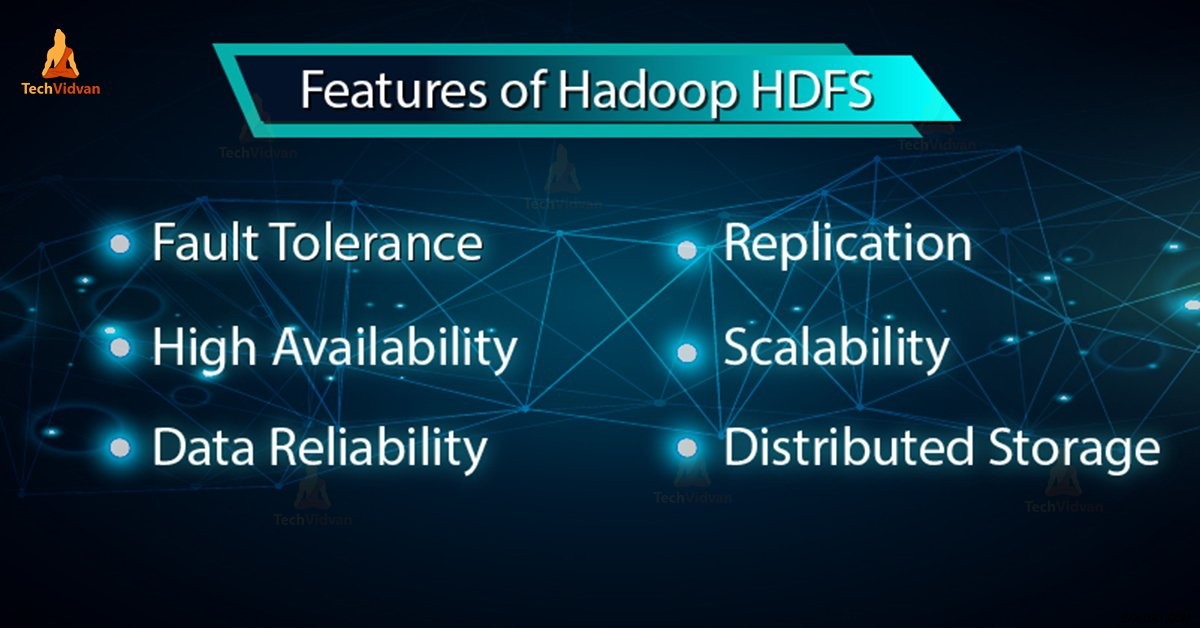

In onze vorige blog hebben we geleerd Hadoop HDFS in detail gaan we nu in deze blog de functies van HDFS bespreken. Hadoop HDFS heeft functies zoals fouttolerantie, replicatie, betrouwbaarheid, hoge beschikbaarheid, gedistribueerde opslag, schaalbaarheid enz.

Al deze functies van HDFS in Hadoop worden besproken in deze Hadoop HDFS-tutorial.

Inleiding tot Hadoop HDFS

Hadoop gedistribueerd bestandssysteem (HDFS) is het primaire opslagsysteem van Hadoop. Het slaat zeer grote bestanden op die op een cluster van standaardhardware worden uitgevoerd. HDFS is gebaseerd op GFS (Google FileSystem). Het slaat gegevens betrouwbaar op, zelfs in het geval van een hardwarestoring.

HDFS biedt ook toegang met hoge doorvoer tot de toepassing door parallel toegang te krijgen. Volgens een voorspelling zal tegen het einde van 2017 75% van de beschikbare gegevens op de planeet zich in HDFS bevinden.

6 Belangrijke kenmerken van HDFS

Laten we, na het bestuderen van de introductie van Hadoop HDFS, nu de belangrijkste kenmerken van HDFS bespreken.

1. Fouttolerantie

De fouttolerantie in Hadoop HDFS is de werkkracht van een systeem in ongunstige omstandigheden. Het is zeer fouttolerant. Hadoop-framework verdeelt gegevens in blokken. Creëert daarna meerdere kopieën van blokken op verschillende machines in het cluster.

Dus wanneer een machine in het cluster uitvalt, kan een client gemakkelijk toegang krijgen tot zijn gegevens vanaf de andere machine die dezelfde kopie van gegevensblokken bevat.

2. Hoge beschikbaarheid

Hadoop HDFS is een maximaal beschikbaar bestandssysteem. In HDFS worden gegevens gerepliceerd tussen de knooppunten in het Hadoop-cluster door een replica te maken van de blokken op de andere slaven die aanwezig zijn in het HDFS-cluster. Dus wanneer een gebruiker toegang wil tot deze gegevens, kunnen ze toegang krijgen tot hun gegevens vanaf de slaves die de blokken bevatten.

Op het moment van ongunstige situaties, zoals het uitvallen van een knooppunt, kan een gebruiker gemakkelijk toegang krijgen tot zijn gegevens vanaf de andere knooppunten. Omdat dubbele kopieën van blokken aanwezig zijn op de andere knooppunten in het HDFS-cluster.

3. Hoge betrouwbaarheid

HDFS biedt betrouwbare gegevensopslag. Het kan gegevens opslaan in het bereik van 100 petabytes. HDFS slaat gegevens betrouwbaar op een cluster op. Het verdeelt de gegevens in blokken. Het Hadoop-framework slaat deze blokken op op knooppunten die aanwezig zijn in het HDFS-cluster.

HDFS slaat gegevens betrouwbaar op door een replica te maken van elk blok dat in het cluster aanwezig is. Daarom biedt fouttolerantie faciliteit. Als het knooppunt in het cluster met gegevens uitvalt, heeft een gebruiker gemakkelijk toegang tot die gegevens vanaf de andere knooppunten.

HDFS maakt standaard 3 replica's van elk blok met gegevens die aanwezig zijn in de knooppunten. Zo zijn gegevens snel beschikbaar voor de gebruikers. Daarom wordt de gebruiker niet geconfronteerd met het probleem van gegevensverlies. HDFS is dus zeer betrouwbaar.

4. Replicatie

Gegevensreplicatie is een uniek kenmerk van HDFS. Replicatie lost het probleem van gegevensverlies op in ongunstige omstandigheden zoals hardwarestoringen, crashen van knooppunten enz. HDFS onderhoudt het replicatieproces met regelmatige tussenpozen.

HDFS blijft ook replica's maken van gebruikersgegevens op verschillende machines die in het cluster aanwezig zijn. Dus wanneer een knooppunt uitvalt, heeft de gebruiker toegang tot de gegevens van andere machines. Er is dus geen mogelijkheid om gebruikersgegevens te verliezen.

5. Schaalbaarheid

Hadoop HDFS slaat gegevens op meerdere knooppunten in het cluster op. Dus wanneer de vereisten toenemen, kunt u het cluster schalen. Er zijn twee schaalbaarheidsmechanismen beschikbaar in HDFS:Verticaal en Horizontale schaalbaarheid.

6. Gedistribueerde opslag

Alle functies in HDFS worden bereikt via gedistribueerde opslag en replicatie. HDFS slaat gegevens op een gedistribueerde manier op over de knooppunten. In Hadoop worden gegevens verdeeld in blokken en opgeslagen op de knooppunten die aanwezig zijn in het HDFS-cluster.

Daarna maakt HDFS de replica van elk blok en slaat het op andere knooppunten op. Wanneer een enkele machine in het cluster crasht, hebben we gemakkelijk toegang tot onze gegevens vanaf de andere knooppunten die de replica bevatten.

Conclusie

Concluderend kunnen we zeggen dat HDFS zeer fouttolerant is. Het slaat op betrouwbare wijze enorme hoeveelheden gegevens op ondanks hardwarestoringen. Het biedt ook hoge schaalbaarheid en hoge beschikbaarheid. Vandaar dat HDFS de Hadoop-functionaliteit mogelijk maakt. Als je een andere functie van HDFS vindt, deel deze dan met ons in het commentaargedeelte hieronder.