Opmerking:dit artikel is oorspronkelijk opgesteld in 2015, maar is in 2019 bijgewerkt om de nieuwe integratie tussen IRI Voracity en Knime (voor Konstanz Information Miner), nu het krachtigste open source dataminingplatform dat beschikbaar is, weer te geven.

Datamining is de wetenschap van het afleiden van kennis uit gegevens, doorgaans grote datasets waarin zinvolle informatie, trends en andere nuttige inzichten moeten worden ontdekt. Datamining maakt gebruik van machine learning en statistische methoden om nuttige informatie te extraheren uit wat anders een zeer intimiderende dataset zou zijn.

Datamining omvat meerdere computer- en wiskundige disciplines. Het is niet zozeer een unitair proces als wel een overkoepelende term voor een reeks acties. Vier brede taken die tijdens mijnbouw worden uitgevoerd, zijn: exploratory data analysis (EDA), beschrijvende modellering, voorspellende modellering en patroondetectie.

EDA gebruikt conventionele statistische visualisatiemethoden of onconventionele grafische methoden om te zien of er iets interessants in de gegevens te vinden is.

Bij beschrijvende modellering worden de gegevens doorgegeven aan een routine en levert het werkwoorden (gegevensgeneratoren) of bijvoeglijke naamwoorden (gegevensbeschrijvingen) op die achter de vorming van de gegevens liggen. Dit omvat methoden die de gegevens associëren met een kansverdeling, clustering en afhankelijkheidsmodellering.

Voorspellende modellering maakt gebruik van regressie- en classificatiemethoden om een standaard op te zetten voor het voorspellen van toekomstige onbekende datapunten. Regressie is een puur wiskundige analyse die een vergelijking aan een gegevensset koppelt om de volgende waarde te voorspellen. Voorspellende modellering kan ook vertrouwen op patroonregels en relatietrends (of zelfs specifiek geïdentificeerde oorzaak en gevolg) trends die zijn ontdekt met behulp van de Logical Analysis of Data (LAD)-methode.

Patroonontdekking via LAD classificeert nieuwe waarnemingen volgens eerdere classificaties van de waarnemingen en gebruikt optimalisatie, combinatorische en Booleaanse functies om de nauwkeurigheid van de analyse te verbeteren.

Voor het grootste deel kunnen deze methoden alleen aangeven welke gegevensinvoer gerelateerd is, maar niet de redenen waarom of hoe ze gerelateerd zijn. Het is mogelijk om uit te leggen wat de ene klasse/cluster van de andere kenmerkt door deze regels of patronen te vinden, en de onderwerpen worden op verschillende manieren weergegeven, afhankelijk van de gegevens zelf.

Toepassingen voor datamining kunnen variëren van zakelijke marketing tot medicijnen, van fraudedetectie in het bank- en verzekeringswezen tot astronomie, van personeelsbeheer tot de catalogusmarketingindustrie, enzovoort. De medische professie heeft het nuttig gevonden om onderscheid te maken tussen kenmerken van mensen met verschillende ziekteprogressiesnelheden. Winkels gebruiken nu datamining om het bestedingspatroon van consumenten beter te begrijpen, te bepalen welke artikelen samen worden gekocht en wat hun relatie is, evenals de beste manier om reclame te maken voor hun klanten. En een groot deel van de bedrijfswereld vertrouwt nu op datamining om belangrijke zakelijke beslissingen te berekenen, uit te voeren en te rechtvaardigen.

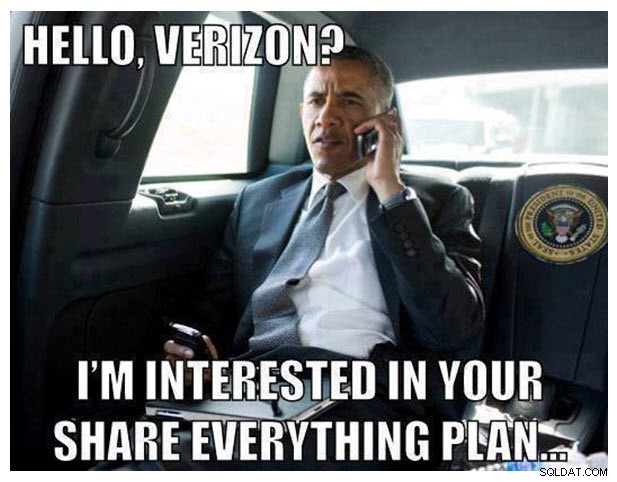

Maar zoals iedereen nu weet uit de recente intense berichtgeving in de media over het telefoonrecordschandaal van de NSA-Verizon, kan datamining ook uiterst controversieel zijn. Voor het geval je onder een steen hebt geleefd, hier is een korte samenvatting:

Op 5 juni 2013 publiceerde het Britse dagblad The Guardian een exclusief rapport dat miljoenen klantrecords van Verizon, een van de grootste telecommunicatieproviders in de VS, werden verzameld door de Amerikaanse National Security Agency, als reactie op een geheime bestelling van de Amerikaanse Foreign Intelligence Surveillance Court. Verizon's Business Network Services zag zich genoodzaakt om alle telefoniemetadata die door de mobiele serviceprovider in de VS en in het buitenland waren gecreëerd, over te dragen. Als gevolg hiervan barstte er een tweeledige en universele kritiek op de regering-Obama los van belangengroepen voor burgerrechten en nieuwsmedia, die beweerden dat presidentieel misbruik van de uitvoerende macht had. Op het moment van schrijven van dit artikel is er geen oplossing voor dit incident in zicht. Maar het zal ongetwijfeld een goed voorbeeld blijven van hoe datamining soms in een negatief daglicht kan worden gesteld, vooral met betrekking tot privacykwesties en het grote publiek.

Bij het omgaan met grote hoeveelheden statische of dynamische gegevens zullen er zeker rekenkundige en I/O-gerelateerde prestatieproblemen zijn. Met databases die terabytes en exabytes aan gegevens bevatten, kan het doorzoeken van de gegevens veel tijd kosten, en de mining-algoritmen moeten zeer efficiënt werken. Enkele andere problemen zijn onder meer overfitting en ruis in gegevens.

Overfitting betekent meestal dat er niet genoeg goede gegevens beschikbaar zijn. Het datamodel (in dit geval de globale beschrijving van de data) wordt te complex omdat het te veel parameters heeft ten opzichte van het aantal waarnemingen. Dit overdrijft kleine fluctuaties in de gegevens, waardoor de betrouwbaarheid van het model als basis voor het maken van voorspellingen in gevaar komt.

Lawaaierige gegevens daarentegen verwijzen naar te veel van de verkeerde soort gegevens. Zinloze, foutieve, ongestructureerde (onleesbare) of anderszins corrupte gegevens verhogen de opslagvereisten en/of vereisen dat statistische analyse wordt verwijderd voordat dit de nauwkeurigheid van datamining kan belemmeren. Goede datamining-algoritmen houden rekening met ruis in data.

Datamining is een enkele stap in een groter proces dat bekend staat als kennisontdekking in databases (KDD). KDD begint eerst met gegevensvoorbereiding: selectie, voorbewerking en transformatie van de gegevens, waarbij je bepaalt wat je wilt bestuderen en het zo instelt dat het kan worden gedolven. Dat is gegevens weergeven als een m-n-matrix en met een numerieke weergave van het element van elke gegevensvector. Volgende, jij de mijne. En ten slotte mag je de oude noggin gebruiken om die informatie te interpreteren en te analyseren. Als de verborgen patronen en trends dan nog niet duidelijk genoeg zijn, moet je wat dieper graven.

De rol van IRI in datamining en het KDD-proces is het gereedmaken en herstructureren van big data voor analyse door middel van meerdere krachtige datatransformatiefuncties. Met name het IRI CoSort-pakket voor gegevensmanipulatie kan gegevens snel filteren, manipuleren en opnieuw formatteren, zodat ze kunnen worden verwerkt door dataminingalgoritmen zoals deze softwaresuites voor datamining. CoSort is ook de standaard gegevensverwerkingsengine in het IRI Voracity-gegevensbeheerplatform, ontworpen voor een breed scala aan gegevensprofilering, voorbereiding en ruziewerk.

Voor degenen die met CoSort in de IRI Workbench GUI werken, is BIRT een gratis Eclipse-plug-in met grafische rapportage- en business intelligence-mogelijkheden, waaronder enkele analyse- en mining-functies. Zowel CoSort als BIRT Analytics gebruiken de Eclipse IDE. Met de ondersteuning van Open Data Access (ODA)-gegevensstuurprogramma's die in CoSort gaan, is de integratie van de gegevensstroom tussen de twee plug-ins ook naadloos en maakt het snellere wat-als-analyses mogelijk.

Voor degenen die in 2019 en daarna met de Voracity werken, raden we aan de kernprovider voor het gratis Knime Analytics Platform in IRI Workbench te installeren. In hetzelfde Eclipse-venster kan het Voracity-bronknooppunt (provider) voor Knime het door Voracity voorbereide onbewerkte gegevens in het geheugen overdragen aan Knime-knooppunten voor toepassingen die statistische en voorspellende analyse, datamining en machine/deep learning, neuraal netwerk vereisen en kunstmatige intelligentie.

Bijdragers aan dit artikel zijn onder meer Roby Poteau en David Friedland